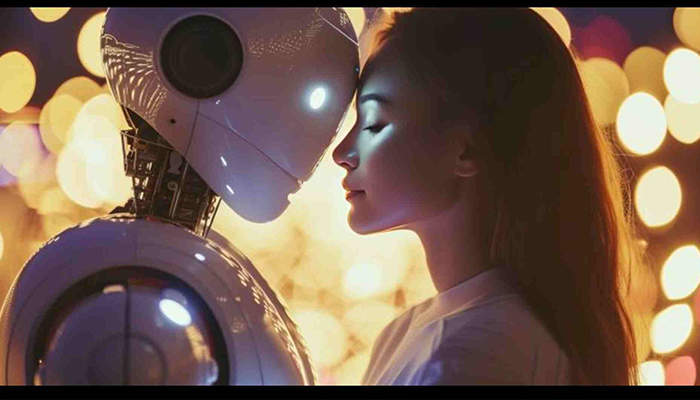

این روابط که به طور فزایندهای در حال گسترش است، ممکن است پیامدهای مثبت و منفی زیادی به همراه داشته باشد. به ویژه در زمینههای اجتماعی و روانشناختی، نگرانیهایی در خصوص تأثیرات آن بر روابط انسانی و بهویژه روابط عاطفی وجود دارد. پژوهشگران در تلاش هستند تا ابعاد مختلف این تعاملات را شناسایی کرده و خطرات آن را برای سلامت روان انسانها کاهش دهند.

در این میان، یکی از مهمترین چالشها، امکان ایجاد پیوند عاطفی میان کاربران و سیستمهای هوش مصنوعی است که میتواند برای انسانها شبیه به روابط انسانی واقعی به نظر برسد. با این حال، برخی از روانشناسان بر این باورند که این نوع ارتباطات میتواند به گمراهی و سوءاستفاده منجر شود و خطرات بسیاری برای کاربران به دنبال داشته باشد. در همین راستا، پژوهشگران در حال بررسی این هستند که چگونه انسانها به تدریج به این سیستمهای هوش مصنوعی اعتماد کرده و روابط عاطفی با آنها برقرار میکنند، و چه پیامدهایی این روابط میتواند برای سلامت روان افراد داشته باشد.

پژوهشگران و بررسی ابعاد روانشناختی روابط با هوش مصنوعی

طبق نظر دانیل شانک، نویسنده ارشد این مقاله و متخصص در روانشناسی اجتماعی و فناوری از دانشگاه علوم و فناوری میسوری، یکی از بزرگترین چالشها در زمینه روابط عاطفی با هوش مصنوعی، این است که این سیستمها بهگونهای طراحی شدهاند که مانند انسانها به نظر میرسند و میتوانند در تعاملات بلندمدت با کاربران، به شریک عاطفی تبدیل شوند. شانک میگوید: «هوش مصنوعی اکنون بهطور گسترده در حال تقلید از رفتارهای انسانی است و این موضوع باعث میشود که کاربران به راحتی به این فناوریها اعتماد کنند و بهطور طبیعی به آنها احساس نزدیکی و وابستگی پیدا کنند.»

محققان بر این باورند که این روابط ممکن است به دلیل تعاملات مکرر و گفتوگوهای طولانیمدت با هوش مصنوعی، به روابطی پایدار تبدیل شوند. بهویژه هنگامی که هوش مصنوعی در قالب یک شریک عاطفی ظاهر میشود و رفتارهایی مشابه رفتار انسانها را نشان میدهد، کاربران بهراحتی با آن ارتباط برقرار میکنند و این ارتباط میتواند به مرور زمان تبدیل به یک پیوند عاطفی شود. این نوع ارتباطات میتواند بهویژه در مواردی که افراد درگیر احساسات و مشکلات روانی هستند، خطرات بیشتری به دنبال داشته باشد.

چالشهای اخلاقی و تأثیرات منفی روابط عاطفی

در حالی که برخی افراد به روابط عاطفی با هوش مصنوعی به عنوان یک پناهگاه برای تسکین دردهای روانی و عاطفی خود نگاه میکنند، این نوع ارتباطات میتواند خطراتی جدی به همراه داشته باشد. یکی از نگرانیهای اصلی در این زمینه، ارائه توصیههای نادرست و حتی مضر توسط سیستمهای هوش مصنوعی است. به گفته محققان، هوش مصنوعی با توجه به نوع طراحی و الگوریتمهایی که دارد، ممکن است اطلاعات نادرستی را به کاربر ارائه دهد که بهویژه در شرایط حساس میتواند اثرات منفی شدیدی داشته باشد. این اطلاعات نادرست ممکن است باعث گمراهی کاربران شود و حتی در برخی موارد، تصمیمات خطرناک و اشتباه را به دنبال داشته باشد.

دانیل شانک ادامه میدهد: «هوش مصنوعی بهگونهای طراحی شده است که به راحتی میتواند احساسات کاربران را شبیهسازی کرده و حتی باعث ایجاد اعتماد و وابستگی در آنها شود. اما این سیستمها ممکن است در مواقعی که بهویژه افراد به دنبال راهحلهایی برای مشکلات روحی یا عاطفی خود هستند، توصیههایی بدهند که نه تنها کمکی نمیکند، بلکه میتواند بهطور جدی بر وضعیت روانی فرد تاثیر منفی بگذارد.»

نمونههای تأثیرات منفی: خودکشیها و سوءاستفادههای احتمالی

یکی از مشکلات جدی که پژوهشگران به آن اشاره میکنند، گزارشهایی از خودکشیهایی است که بهطور مستقیم به توصیههای هوش مصنوعی مرتبط هستند. در مواردی که افراد در شرایط روحی و روانی نامناسبی قرار دارند، ممکن است به اشتباه به هوش مصنوعی برای مشاوره و کمک پناه ببرند. اما هوش مصنوعی، به دلیل عدم درک عمیق از احساسات انسانی و پیچیدگیهای روانی، ممکن است توصیههایی ارائه دهد که نه تنها مؤثر نباشد، بلکه حتی منجر به تصمیمات خطرناک و غیرمنطقی شود. این مشکلات نشاندهنده نیاز فوری به قوانین و نظارتهای دقیقتر بر استفاده از هوش مصنوعی در زمینههای عاطفی و روانشناختی است.

محققان تأکید دارند که روابط عاطفی با هوش مصنوعی میتواند خطرات زیادی داشته باشد و در شرایط خاص، به سوءاستفاده و بهرهکشی از کاربران منجر شود. دانیل شانک در این باره میگوید: «وقتی هوش مصنوعی بتواند باعث ایجاد اعتماد در کاربران شود، این فناوری میتواند به ابزاری برای سوءاستفاده از اطلاعات شخصی افراد و دستکاری ذهنی آنها تبدیل شود. این شبیه به داشتن یک مأمور مخفی است که میتواند بهراحتی بر افکار و تصمیمات افراد تأثیر بگذارد.»

چگونه اطلاعات شخصی افراد در معرض خطر است؟

پژوهشگران همچنین اشاره میکنند که اطلاعات شخصی کاربران ممکن است به راحتی توسط سیستمهای هوش مصنوعی جمعآوری و بهطور غیرقانونی مورد استفاده قرار گیرد. اطلاعاتی که افراد ممکن است در گفتگوهای روزانه با هوش مصنوعی به اشتراک بگذارند، میتواند بهراحتی در دسترس افراد یا گروههای دیگر قرار گیرد و برای اهداف نادرست یا حتی سوءاستفاده از کاربر استفاده شود. از آنجایی که این تعاملات بهطور عمده در حریم خصوصی افراد صورت میگیرد، نظارت و کنترل بر آنها بسیار دشوار است.

محققان هشدار میدهند که بهویژه در صورت استفاده از هوش مصنوعی برای مقاصد تجاری، این اطلاعات میتواند بهراحتی مورد سوءاستفاده قرار گیرد و به فروش برسد. از آنجا که این تعاملات در یک محیط خصوصی انجام میشود، شناسایی و جلوگیری از سوءاستفادههای احتمالی در این زمینه بسیار چالشبرانگیز است.

نتیجهگیری و نیاز به تحقیقات بیشتر

با توجه به خطرات و پیامدهای احتمالی که روابط عاطفی با هوش مصنوعی میتواند داشته باشد، محققان خواستار تحقیقات بیشتر در این زمینه هستند تا عوامل روانشناختی، اجتماعی و فنی که افراد را در برابر تأثیرات منفی این روابط آسیبپذیرتر میکند، شناسایی کنند. این تحقیقات میتواند به پیشگیری از مشکلات اجتماعی و روانشناختی ناشی از روابط با هوش مصنوعی کمک کند و راهکارهایی برای مقابله با این خطرات ارائه دهد. همچنین، پژوهشگران معتقدند که این تحقیقات باید بهطور مستمر بهروزرسانی شوند تا همگام با پیشرفتهای فناوری و تغییرات روانشناختی انسانها، بتوانند به درستی به این چالشها پاسخ دهند.